De seneste uger har de toneangivende medier været fyldt med selvransagelse: ”Vi lader os rive med af positive meningsmålinger”; ”Målinger overbeviser vælgerne” og ”Politiske prognoser flytter stemmer”.

De refererer alle til en ny forskningsrapport fra Institut for Statskundskab på Københavns Universitet forfattet af Kasper Møller Hansen m.fl. – med titlen: Hvordan påvirkes vælgerne af meningsmålinger?

Projektet er interessant – ikke mindst set i lyset af DR’s uheldige exitprognose ved seneste kommunalvalg. For spørgsmålet er jo, om DR – og refererende medier – har påvirket vælgerne og dermed valgresultatet med den tidlige skæve måling?

Nu er det undersøgt, for første gang i en dansk sammenhæng, via et såkaldt survey-eksperiment. Her har man inddelt ca. 3.000 repræsentativt udvalgte danskere i fire stimuligrupper og en kontrolgruppe, hver især bestående af ca. 600 personer, og herefter præsenteret stimuligrupperne for meningsmålinger og tilhørende nyhedsartikler, som giver fiktiv frem- eller tilbagegang for henholdsvis Socialdemokraterne og De Konservative. Så har man stillet de 3.000 danskere en række spørgsmål, herunder hvad de ville stemme, hvis der var folketingsvalg i morgen, og herudfra estimeret stimulieffekterne – altså mulige fremgangs- og tilbagegangseffekter.

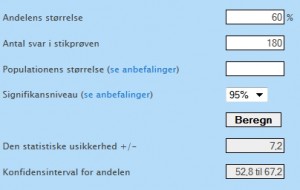

Undersøgelsen konkluderer, at det er ”sandsynliggjort, at når et parti går frem i meningsmålingerne, kan det give dem et ekstra boost blandt vælgerne” og ”… der er en tendens til, at positive meningsmålinger sender partierne frem, mens dårlige målinger kan sende dem tilbage”. Definitionen af boost vil jeg overlade til andre, men faktum er, at undersøgelsen sandsynliggør en ganske lille fremgangseffekt (bandwagon effekt). For Socialdemokraternes vedkommende fraviger man i undersøgelsen det ellers bredt anerkendte krav om et 5 procents signifikansniveau. Effekten er blot signifikant på et 10 procents signifikansniveau.

I forskningssammenhæng taler man om, at en effekt kan være stærkt signifikant, svagt/marginalt signifikant eller slet ikke signifikant. Et 10 procents signifikansniveau vil i mange forskningssammenhænge betegnes ”ikke signifikant” eller ”marginalt signifikant”. Det er et gråzoneområde. Begrundelsen er, at der er en ikke ubetydelig risiko for, at den målte forskel blot er ”tilfældig støj” – altså, at der ingen virkelig effekt er. I fagsproget taler man om risikoen for fejlagtigt at forkaste en sand H0-hypotese, en såkaldt type 1 fejl. Hvis H0-hypotesen er sand, er der ingen effekt. Denne risiko er til stede her, også selv om eksperimentet forventes at have høj intervaliditet (høj intervaliditet: At den observerede stemmeeffekt kan tilskrives stimuli – her meningsmåling og artikel – og ikke andre “forstyrrende” årsager).

Min kritik af undersøgelsens hovedresultater – når man ser på stemmeadfærd – kan i forlængelse heraf sammenfattes i to pointer, som ikke afspejles i de seneste ugers mediedækning:

Pointe 1: Havde der været tale om virkelige meningsmålinger hver især baseret på ca. 600 svar og med samme fremgang i tilslutningen til Socialdemokraterne, ville fagpersoner rådgive journalister til ikke at vinkle på forskellen pga. den statistiske usikkerhed. Med henvisning til eksperimentets høje intervaliditet og evidens fra lignende eksperimenter mener forskerne, at det er forsvarligt her. Det fremgår dog ingen steder i rapporten eller i medieomtalen, at der er tale om marginal signifikans.

Pointe 2: Tilbagegangseffekterne er insignifikante, dvs. ikke sandsynliggjort i undersøgelsen. Men når det er tilfældet, hvordan kan rapporten så konkludere en tendens til, at dårlige målinger kan sende partierne tilbage? Det virker ikke stærkt underbygget i eksperimentets resultater.

Dertil kommer en tredje væsentlig pointe, som handler om selve forskningsdesignet, altså at der er tale om et survey-eksperiment: Fremgangseffekterne ville næppe være målbare ved et virkeligt valg, fordi man ved virkelige valg påvirkes af mange modsatrettede faktorer, og fordi de fleste danskere ikke læser en bestemt meningsmåling og ditto nyhedsartikel. Dette forhold diskuteres behørigt i forskningsrapporten og er et grundvilkår ved denne type forskningsdesign. Og jeg lever gerne med det – når blot det ikke negligeres i formidlingen af undersøgelsens resultater. Det, mener jeg desværre, er sket i flere af artiklerne.

Man har i landsdækkende medier kunnet læse, at der er tale om ”ret store effekter”, ”at det kan være ret fatalt at udkomme med en tidlig meningsmåling”, at der ”gerne kommer 3,4 procent oveni, hvis et parti går 5 procent frem”, at ”S kan have tabt på, at vælgerne har fået at vide, at det gik dårligt” – kort sagt: Man får indtryk af, at meningsmålinger kan påvirke et valgresultat i betydelig grad.

Men alle de nævnte citater, fortolkninger og vinkler er for hårdt strammede. Effekterne ved et virkeligt valg er nærmest umulige at estimere på baggrund af et eksperiment, som det man her har gennemført. Undersøgelsen dokumenterer ikke store effekter med potentielt fatale konsekvenser for fx Socialdemokraterne ved efterårets kommunalvalg.

Nu handler undersøgelsen ikke blot om stemmeadfærd. Stimulieffekter på ”partisympati” undersøges også. Og stemmeadfærdseffekterne for De Konservative er i undersøgelsen større end for Socialdemokraterne. Samlet set sandsynliggør undersøgelsen, at vælgere faktisk påvirkes af fremgangsmålinger. Men det ændrer ikke ved, at hovedparten af stemmeadfærdseffekterne er insignifikante eller marginalt signifikante med almindelig målestok, og at fremgangseffekten i populationen kan være meget begrænset.

Berlingske citerer Kasper Møller Hansen for at sige, at ”der hviler et stort ansvar på nyhedsmedierne som formidlere af meningsmålinger”. Enig. Men, kunne man tilføje, der hviler også et stort ansvar på selvsamme medier som formidlere af undersøgelser om meningsmålingers effekt. Og et ditto ansvar hos forskerne bag undersøgelsen for, at resultaterne ikke overeksponeres.