Institut for Lykkeforskning har sat 1.200 danskere på Facebookafvænning, kunne man forleden læse i Politiken og en række andre danske medier. Og det har de haft godt af. Afvænningen forstås.

Måske skulle man prøve medicinen? – tænkte jeg ved mig selv. Men først ville jeg godt vide lidt mere om undersøgelsen bag, så jeg dykkede ned i rapporten.

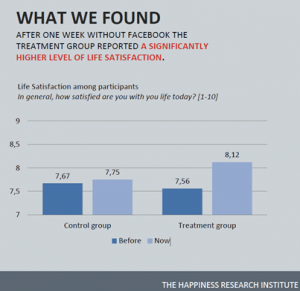

Der er tale om et eksperiment, hvor cirka 600 danskere i en uge skulle undvære Facebook (den såkaldte treatmentgruppe), mens cirka 500 danskere blot skulle fortsætte deres sædvanlige forbrug (kontrolgruppen). Ved hjælp af spørgeskemaer har man henholdsvis før og efter ”eksperimentugen” stillet såvel kontrol- som treatmentgruppen en række enslydende spørgsmål relateret til lykke og livstilfredshed. På hvert spørgsmål har man kunnet angive tilfredshed, aktivitet etc. på skalaer fra enten 1-5 eller 1-10.

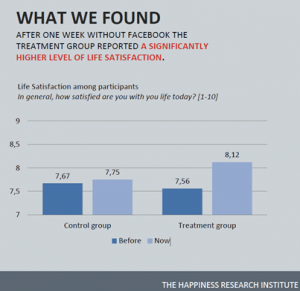

Gennemsnitsscorerne på spørgsmålet om livstilfredshed henholdsvis før og efter så således ud:

Efter en uge uden Facebook rapporterer treatmentgruppen ”a significantly higher level of life satisfaction”.

Dejligt, tænkte jeg. En signifikant højere livstilfredshed. Men samtidig nagede tvivlen i mig. For manglede jeg ikke nogle informationer? Hvordan kan man som journalist – eller helt almindelig læser – vurdere undersøgelsens troværdighed?

Man kan fx starte her:

1. Signifikant højere i forhold til hvad? Er det i forhold til kontrolgruppen? Eller i forhold til treatmentgruppens egen livstilfredshed før eksperimentets start?

2. Hvad betyder ”signifikant højere niveau” egentlig? Er det på et 5 procents signifikansniveau? Eller et 1 procents signifikansniveau? Eller noget tredje?

3. Hvorfor fortæller rapporten kun, at lige netop dette resultat er signifikant? Skyldes det, at Facebook-effekterne målt på alle de andre spørgsmål, som stilles, ikke er signifikante?

4. Skal man se på (og rapportere) før-efter tallene inden for treatmentgruppen, eller bør man sammenligne kontrolgruppens og treatmentgruppens efter-resultater, hvis man vil udtale sig om en mulig effekt? Altså, hvilke tal bør journalisten (efter dialog med instituttet) sammenligne og vinkle ud fra?

5. Er der ikke en eksperimenteffekt, som man skal forholde sig til? Altså, når nu kontrolgruppen scorer højere på samtlige tilfredshedsspørgsmål efter en uge, hvor de absolut ingen ”medicin” har fået? Bliver de lykkeligere af at være med i eksperimentet? Skulle vi så ikke ordinere nogle flere eksperimenter til alle mellemfornøjede danskere?

6. Kan jeg overføre resultaterne til mit eget liv? Der er jo tale om gennemsnitstal, altså gennemsnitlige effekter. Men vi er vel ret forskellige som Facebook-brugere? Nogle er meget aktive, andre er mere passive. Nogle er tilsyneladende altid på (kender du typen?), mens andre har et mere moderat forbrug. Er der risiko for en niveaufejlslutning her? Og kunne man ikke nedbryde treatmentgruppen i nogle ”typer” Facebook-brugere, som man bedre selv kan spejle sig i?

Alle disse spørgsmål tårnede sig op. Nyhedsartiklerne om eksperimentet gav ikke svar på spørgsmålene. Rapporten fra Institut for Lykkeforskning gjorde heller ikke. Og det var jo egentlig alt sammen relevante opklarende journalistiske spørgsmål.

Jeg kontaktede derfor folkene bag undersøgelsen, og de var heldigvis flinke til at svare. For der findes selvfølgelig – selvfølgelig! – svar på alle disse spørgsmål:

Stigningen i livskvalitet, som medierne rapporterede, var stigningen inden for treatmentgruppen – altså gennemsnitsscoren henholdsvis før (7,56) og efter (8,12). Og den er statistisk signifikant på ethvert rimeligt signifikansniveau (p<0,01). Som enhver journalistdimittend fra Danmarks Medie- og Journalisthøjskole er klar over, kan jeg kun lave denne beregning, hvis jeg kender standardafvigelserne (da der er tale om gennemsnitsscorer). Disse fremsendte Institut for Lykkeforskning beredvilligt, og så var det enkelt at kontrolberegne i et regneark.

Men burde man ikke i stedet have rapporteret forskellen mellem kontrolgruppen og treatmentgruppen? Kunne det ikke imødegå indvendingen i forhold til en mulig eksperimenteffekt? Jo. Er der gode journalistiske grunde til IKKE at gøre dette, og i stedet vinkle på den størst mulige observerede effekt i undersøgelsen, altså stigningen fra 7,56 til 8,12? Nej.

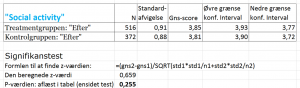

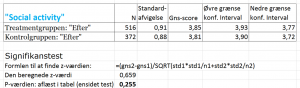

Effekterne på det sociale liv målt som sociale aktiviteter og tilfredsheden med samme (altså nogle af undersøgelsens øvrige spørgsmål) – var de så faktisk statistisk signifikante? Nej. Ikke på et niveau, der gør det rimeligt at rapportere. Det er velsagtens (?) derfor, rapporten forbigår det i tavshed. Man kunne godt interessere sig journalistisk for dette, altså for de dele af undersøgelsen, som ikke fremhæves – for de ting, der ikke fremgår eksplicit af rapporten.

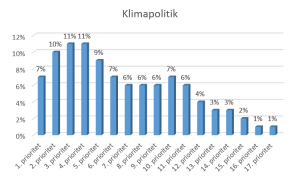

Nørde-alert (følgende kan springes over): Herunder ses signifikanstesten af effekten observeret på spørgsmålet om “Social Activity”, altså testen af om forskellen på de to gennemsnitsscorer på henholdsvis 3,85 og 3,81 er signifikant. Med så høj en p-værdi (p=0,255) er forskellen mellem kontrol- og treatmentgruppe, altså effekten på “Social Activity” af at undvære Facebook, ikke statistisk signifikant (for de særligt interesserede: Klik på billedet for at se det i fuld størrelse):

Nørde-alert ophævet.

Hvad så med den tilsyneladende eksperimenteffekt, altså den kendsgerning, at kontrolgruppen på alle målte parametre fik det ”bedre” af at være med i eksperimentet? En mulig plausibel forklaring er, at de har ændret adfærd i eksperimentugen, altså at deltagerne i kontrolgruppen af egen drift har valgt ikke at være så meget på Facebook, som de ellers er. Sådan lyder forklaringen fra folkene bag undersøgelsen. Det havde været relevant at oplyse i rapporten og relevant at spørge ind til journalistisk.

Hvad så med mig? Eksperimentet tyder jo på, at det faktisk hjælper på livstilfredshed (og muligvis en række andre ting) at drosle ned eller helt droppe Facebook. Men man kan IKKE slutte til individniveau fra en undersøgelse som denne. Effekten på mig (eller dig) kan være helt anderledes. Måske får jeg det faktisk bedre af at være på Facebook. Faktisk har folkene bag undersøgelsen nedbrudt resultaterne på en række interessante undergrupper, men disse analyser er endnu ikke offentliggjort.

Undersøgelsen er interessant. Og der kommer sikkert endnu mere interessante opfølgende undersøgelser. Gerne med lidt større detaljeringsgrad og metodeformidling i både afrapportering og den journalistiske formidling.