Uanset hvilke medier man følger, kan man næsten dagligt læse, at den seneste meningsmåling viser.

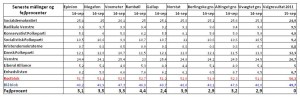

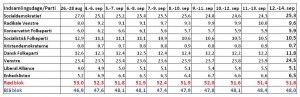

Ethvert større dansk mediehus har sin egen hel eller halveksklusive aftale med et analyseinstitut: Epinion, TNS Gallup, Voxmeter, YouGov, Megafon og hvad de nu ellers hedder.

Men hvordan arbejder institutterne egentlig? Og hvad skal man som journalist eller bare almindelig medieforbruger være opmærksom på rent metodisk? Jeg vil her ridse nogle af de metodiske forskelligheder og karakteristika op.

Adgang til svarpersoner

Der anvendes grundlæggende tre indsamlingsmetoder: Telefoninterviews (CATI), webpaneler (CAWI) og en kombination af begge. YouGov anvender udelukkende webpanel, mens flertallet af de øvrige institutter arbejder med en kombi-model (fx med fordelingen 50-50, 60-40 eller 80-20). Der findes også institutter, som kun anvender CATI til politiske meningsmålinger. Og for at gøre forvirringen total er der også institutter, som varierer metoderne nærmest fra måling til måling.

Traditionelt har man kritiseret webpaneler for ikke at være repræsentative. Kritikken går blandt andet på, at ældre mennesker og lavtuddannede er underrepræsenterede, og at man påvirker folk i panelet gennem de spørgsmål, man stiller dem. Løbende udskiftning af panelets medlemmer kan til en vis grad afbøde problemet med påvirkning. Erfaringer fra bl.a. folketingsvalget i 2011 viser imidlertid, at webpaneler i nogle tilfælde ramte mere præcist end telefonbaserede målinger. Det er med andre ord ikke længere helt så selvfølgeligt, at CATI er bedst. Det er til gengæld klart, at CAWI er billigst. Kombi-metoden har dog stadig den – i hvert fald teoretiske – fordel, at man bedre kan sikre en demografisk repræsentativ svargruppe.

Kvaliteten af webpanelet

Kvaliteten af webpanelerne er – og bliver i tiltagende grad – et afgørende konkurrenceparameter. Her skal man særligt være opmærksom på panelets størrelse og sammensætning, den løbende udskiftning af panelets medlemmer og de baggrundsoplysninger, man indhenter på medlemmerne. Man skal også være opmærksom på, hvordan respondenterne er rekrutteret og eventuelle skævheder som følge heraf – er de fx selvrekrutterede eller inviterede eller købt fra et eller andet medlemsregister? Erfaring med webpaneler er et andet afgørende parameter. Det tager tid (og valg) at opdage et webpanels eventuelle indbyggede skævheder og lære at justere med relevante vægte.

Indsamling via webpaneler

Man skulle måske tro, at indsamlingen af panel-svar foregår på samme måde på tværs af institutterne. Det er dog ikke tilfældet. Nogle institutter anvender præstratificering, hvor de på forhånd udtrækker en repræsentativ stikprøve blandt panelets medlemmer. Hvis man her opnår en svarprocent nær 100, behøver man faktisk ikke nogen efterfølgende vægtning af svarene eller løbende kontrol. Det kræver dog, at man bruger ressourcer på at sikre en meget høj svarprocent.

Andre institutter anvender kvoteopfyldelse, hvor repræsentativiteten sikres løbende og automatisk i takt med, at svarene tikker ind. Her registreres med andre ord de hurtigste svar blandt panelets medlemmer. Det åbner op for nogle mulige skævheder, som ikke gør sig gældende ved præstratificerede stikprøver.

Endelig er der institutter, som kombinerer metoderne ved at udtrække en præstratificeret stikprøve og herefter løbende følger, om kvoterne opnås på de enkelte strata (og løbende supplerer kvoterne, hvor der måtte mangle svar). Det er naturligvis nødvendigt, hvis man ikke opnår den helt høje svarprocent, og der er systematiske skævheder.

Håndtering af tvivlere

Ved politiske meningsmålinger stiller institutterne det enslydende spørgsmål: Hvilket parti ville du stemme på, hvis der var folketingsvalg i morgen? Det er imidlertid ikke alle danskere, der har en klar holdning til partivalg. Nogle – ofte 10-15 procent – udtrykker i første omgang tvivl, når man stiller dem spørgsmålet. De fleste institutter prober. Det betyder, at de forsøger at vriste et svar ud af tvivlerne, fx ved at stille et opfølgende spørgsmål: Hvilket parti vil du mest sandsynligt stemme på? Eller: Hvilke partier kunne komme på tale/hælder du til? Det får en del af tvivlerne til at tilkendegive en holdning, og disse lidt usikre stemmer regnes så typisk ind på lige fod med dem, der har en sikker politisk overbevisning. Tilbage står en lille restgruppe af hårde tvivlere. De fleste institutter oplyser, at denne restgruppe smides ud eller ikke tillægges nogen betydning, når de estimerer mandat- og procentfordelingerne. Argumentet er, at det er for usikkert at forsøge at gætte dem ud. Nogle af disse tvivlere vil givetvis også tilhøre gruppen af sofavælgere eller stemme blankt.

Imidlertid indgår tvivlergruppen som regel i den oplyste sample size, dvs. i den oplyste stikprøve. Det betyder i praksis, at gruppen behandles, som om den ville stemme som ikke-tvivlerne. I virkeligheden burde man enten fjerne denne gruppe fra den oplyste stikprøve eller tydeligt skrive, at tvivlergruppen udgør xx procent og bør trækkes fra stikprøven, hvis man ønsker at beregne den statistiske usikkerhed. Måske flueknepperi og marginalt, men alligevel. Der findes givetvis også institutter, som vægter tvivlerne ind. Men her er vi inde og pille ved forretningshemmelighederne.

Metodisk forskellighed

Der er selvfølgelig andre ting, der differentierer institutterne: Hvordan vægter man svarene – hvis man vægter dem? Hvordan håndterer man førstegangsvælgere? Hvordan håndterer man, at folk har svært ved at huske (eller har fortrængt), hvad de stemte ved seneste valg?

Pointen er, at der formentlig er større metodisk forskellighed mellem institutterne, end de fleste forestiller sig. Og at vi pt. befinder os i en overgangsfase i forhold til adgang til svarpersoner.

Det er imidlertid vanskeligt at rangordne institutterne. Målingerne op til seneste folketingsvalg viste, at ingen af institutterne ramte helt skævt – eller helt præcist. Institutterne er nogenlunde enige om at spørge mellem 1000 og 1500 personer. Her kunne de differentiere sig. Og fx spørge 5000 repræsentative danskere. Det ville give større præcision – uanset metode.

(Dette indlæg bygger bl.a. på interviews med en række af de toneangivende danske analyseinstitutter)

HS Analyse

afsl. 2.3.

Facebook

afsl. 8.3.

9.3.

12.03

800