Nogle analyseinstitutter måler konsekvent tilslutningen til bestemte partier for højt eller lavt. Nu kan medier undgå at blive snydt.

Det har jeg skrevet en klumme om på DMJX Valgcenter. Du kan læse den her.

Kategoriarkiv: Meningsmålinger

Forstå din meningsmåling – helt

Folketingsvalget nærmer sig, og det samme gør en lavine af meningsmålinger. DRs Detektor har i den anledning produceret en videoguide, som præsenteres under overskriften Undgå at blive narret af en meningsmåling.

Videoen (og den forklarende tekst på DR’s site) giver en på mange måder udmærket pædagogisk introduktion til fænomenet, som så mange af os elsker at hade. Men den fortæller ikke hele historien, og dermed risikerer man faktisk – paradoksalt – at blive narret af en meningsmåling. Hvis man altså tager DR’s forklaringer for pålydende.

Det er jo en skam – og helt sikkert ikke meningen. Men hvad er problemet da? Jo, DR skriver: “Spørger man cirka 1.000 personer, når man et resultat med en usikkerhed på blot to til tre procent”. Sådan! Det er jo dejligt at vide som læser. Det er bare ikke hele historien.

Det, vi ikke får at vide, er, at usikkerheden på blot 2-3 procentpoint (ja, det er faktisk procentpoint. Det skulle der have stået på DR’s site) er under forudsætning af, at man anvender et 95 procents konfidensniveau. Er det nu så vigtigt med konfidensniveauet? Ja, det er det faktisk. For det betyder, at der er en kalkuleret risiko for, at man tager fejl. At tage fejl betyder her, at meningsmålingen viser MERE end 2-3 procentpoint forkert. Og denne risiko fortæller DR ikke noget om.

Faktisk tager man fejl 1 ud af 20 gange, når man anvender et 95 procents konfidensniveau. Altså i 1 ud af 20 målinger. Den risiko lever de fleste af os nok fint med i det daglige. Også undertegnede. Men vil du forstå din meningsmåling, skal du vide, at der altid er en (lille) risiko for, at meningsmålingen viser mere end de ellers anførte maksimale 2-3 procentpoint forkert.

Den gode nyhed er, at du faktisk kan gøre noget ved det. Du kan nemlig lade være med at stole blindt på enkeltmålinger og i stedet sætte din lid til gennemsnit af mange aktuelle målinger. Tjek fx Berlingske Barometer eller Ritzau Indeks. Her er risikoen for at tage fejl meget mindre end ved enkeltmålinger.

Fup, fejl og fordrejninger

Vil du gerne være din egen detektor? Eller bare blive bedre til at gennemskue tal, fakta og statistik i medierne? Så kan jeg kraftigt anbefale, at du investerer i netop udkomne “Fup, fejl og fordrejninger. Bliv din egen detektor”.

Indrømmet, jeg er ikke en helt uhildet betragter. Jeg er begejstret over, at vi i Danmark har et program som Detektor, og jeg har indimellem selv medvirket i udsendelserne.

Med det sagt, så er det en særdeles oplysende, velskrevet, mundret og eksempelrig bog, Thomas Buch-Andersen og Mads Bøgh Johansen er barslet med. Bogen er inddelt i 11 tematiske kapitler, og det er faktisk bogens helt åbenlyse styrke. Temaerne giver dig hurtigt et overblik over, hvilke typiske fejl og fordrejninger man som mediebruger (eller journalist, politiker, kommunikatør etc.) skal være særligt opmærksom på – tested by reality. Hvis jeg skal fremhæve enkelte temaer, så må det blive “om cherry-picking” – altså når man ved selektiv brug af tal tegner et forkert billede af helheden, “om årsagssammenhænge”, som ofte er nogle helt andre, “om sammenligninger”, som kræver sammenlignelige størrelser, og “om inflation”, som ofte “glemmes”, når priserne igen-igen er rekordhøje. Der er også et udmærket kapitel om meningsmålinger og spørgeskemabaserede undersøgelser, men det bliver dog mest til en indledende introduktion til de typiske validitetsproblemer.

Alle kapitler er krydret med Detektors egne eksempler, og de er både lærerige og underholdende. Bogen indeholder desuden en række korte bidrag fra politikere, erhvervs- og mediefolk, som selv har været en tur i Detektormøllen. Der er – som det nok fremgår – ikke tale om en lærebog. Du lærer ikke, hvordan du finder supplerende tal hos Danmarks Statistik, hvordan du tester for spuriøse sammenhænge, hvordan du korrigerer fra løbende til faste priser, eller hvordan du beregner statistisk usikkerhed ved meningsmålinger. Hvis du skal “kunne selv”, kræver det naturligvis mere end at læse denne bog.

Men med bogen under huden har du alle muligheder for at blive en mere kritisk og vågen medieforbruger. Så læs den. Også – og ikke mindst! – hvis du er journaliststuderende.

Påvirker meningsmålinger faktisk vælgerne?

De seneste uger har de toneangivende medier været fyldt med selvransagelse: ”Vi lader os rive med af positive meningsmålinger”; ”Målinger overbeviser vælgerne” og ”Politiske prognoser flytter stemmer”.

De refererer alle til en ny forskningsrapport fra Institut for Statskundskab på Københavns Universitet forfattet af Kasper Møller Hansen m.fl. – med titlen: Hvordan påvirkes vælgerne af meningsmålinger?

Projektet er interessant – ikke mindst set i lyset af DR’s uheldige exitprognose ved seneste kommunalvalg. For spørgsmålet er jo, om DR – og refererende medier – har påvirket vælgerne og dermed valgresultatet med den tidlige skæve måling?

Nu er det undersøgt, for første gang i en dansk sammenhæng, via et såkaldt survey-eksperiment. Her har man inddelt ca. 3.000 repræsentativt udvalgte danskere i fire stimuligrupper og en kontrolgruppe, hver især bestående af ca. 600 personer, og herefter præsenteret stimuligrupperne for meningsmålinger og tilhørende nyhedsartikler, som giver fiktiv frem- eller tilbagegang for henholdsvis Socialdemokraterne og De Konservative. Så har man stillet de 3.000 danskere en række spørgsmål, herunder hvad de ville stemme, hvis der var folketingsvalg i morgen, og herudfra estimeret stimulieffekterne – altså mulige fremgangs- og tilbagegangseffekter.

Undersøgelsen konkluderer, at det er ”sandsynliggjort, at når et parti går frem i meningsmålingerne, kan det give dem et ekstra boost blandt vælgerne” og ”… der er en tendens til, at positive meningsmålinger sender partierne frem, mens dårlige målinger kan sende dem tilbage”. Definitionen af boost vil jeg overlade til andre, men faktum er, at undersøgelsen sandsynliggør en ganske lille fremgangseffekt (bandwagon effekt). For Socialdemokraternes vedkommende fraviger man i undersøgelsen det ellers bredt anerkendte krav om et 5 procents signifikansniveau. Effekten er blot signifikant på et 10 procents signifikansniveau.

I forskningssammenhæng taler man om, at en effekt kan være stærkt signifikant, svagt/marginalt signifikant eller slet ikke signifikant. Et 10 procents signifikansniveau vil i mange forskningssammenhænge betegnes ”ikke signifikant” eller ”marginalt signifikant”. Det er et gråzoneområde. Begrundelsen er, at der er en ikke ubetydelig risiko for, at den målte forskel blot er ”tilfældig støj” – altså, at der ingen virkelig effekt er. I fagsproget taler man om risikoen for fejlagtigt at forkaste en sand H0-hypotese, en såkaldt type 1 fejl. Hvis H0-hypotesen er sand, er der ingen effekt. Denne risiko er til stede her, også selv om eksperimentet forventes at have høj intervaliditet (høj intervaliditet: At den observerede stemmeeffekt kan tilskrives stimuli – her meningsmåling og artikel – og ikke andre “forstyrrende” årsager).

Min kritik af undersøgelsens hovedresultater – når man ser på stemmeadfærd – kan i forlængelse heraf sammenfattes i to pointer, som ikke afspejles i de seneste ugers mediedækning:

Pointe 1: Havde der været tale om virkelige meningsmålinger hver især baseret på ca. 600 svar og med samme fremgang i tilslutningen til Socialdemokraterne, ville fagpersoner rådgive journalister til ikke at vinkle på forskellen pga. den statistiske usikkerhed. Med henvisning til eksperimentets høje intervaliditet og evidens fra lignende eksperimenter mener forskerne, at det er forsvarligt her. Det fremgår dog ingen steder i rapporten eller i medieomtalen, at der er tale om marginal signifikans.

Pointe 2: Tilbagegangseffekterne er insignifikante, dvs. ikke sandsynliggjort i undersøgelsen. Men når det er tilfældet, hvordan kan rapporten så konkludere en tendens til, at dårlige målinger kan sende partierne tilbage? Det virker ikke stærkt underbygget i eksperimentets resultater.

Dertil kommer en tredje væsentlig pointe, som handler om selve forskningsdesignet, altså at der er tale om et survey-eksperiment: Fremgangseffekterne ville næppe være målbare ved et virkeligt valg, fordi man ved virkelige valg påvirkes af mange modsatrettede faktorer, og fordi de fleste danskere ikke læser en bestemt meningsmåling og ditto nyhedsartikel. Dette forhold diskuteres behørigt i forskningsrapporten og er et grundvilkår ved denne type forskningsdesign. Og jeg lever gerne med det – når blot det ikke negligeres i formidlingen af undersøgelsens resultater. Det, mener jeg desværre, er sket i flere af artiklerne.

Man har i landsdækkende medier kunnet læse, at der er tale om ”ret store effekter”, ”at det kan være ret fatalt at udkomme med en tidlig meningsmåling”, at der ”gerne kommer 3,4 procent oveni, hvis et parti går 5 procent frem”, at ”S kan have tabt på, at vælgerne har fået at vide, at det gik dårligt” – kort sagt: Man får indtryk af, at meningsmålinger kan påvirke et valgresultat i betydelig grad.

Men alle de nævnte citater, fortolkninger og vinkler er for hårdt strammede. Effekterne ved et virkeligt valg er nærmest umulige at estimere på baggrund af et eksperiment, som det man her har gennemført. Undersøgelsen dokumenterer ikke store effekter med potentielt fatale konsekvenser for fx Socialdemokraterne ved efterårets kommunalvalg.

Nu handler undersøgelsen ikke blot om stemmeadfærd. Stimulieffekter på ”partisympati” undersøges også. Og stemmeadfærdseffekterne for De Konservative er i undersøgelsen større end for Socialdemokraterne. Samlet set sandsynliggør undersøgelsen, at vælgere faktisk påvirkes af fremgangsmålinger. Men det ændrer ikke ved, at hovedparten af stemmeadfærdseffekterne er insignifikante eller marginalt signifikante med almindelig målestok, og at fremgangseffekten i populationen kan være meget begrænset.

Berlingske citerer Kasper Møller Hansen for at sige, at ”der hviler et stort ansvar på nyhedsmedierne som formidlere af meningsmålinger”. Enig. Men, kunne man tilføje, der hviler også et stort ansvar på selvsamme medier som formidlere af undersøgelser om meningsmålingers effekt. Og et ditto ansvar hos forskerne bag undersøgelsen for, at resultaterne ikke overeksponeres.

Gætværk

Et nyt – og problematisk – argument for at tage meningsmålinger for pålydende er begyndt at dukke op blandt journalister og journaliststuderende:

Man anerkender, at de små ændringer i partiernes tilslutning ligger inden for den statistiske usikkerhed, men argumenterer samtidig for, at det er mest sandsynligt, at tilslutningen (altså den virkelige tilslutning blandt alle myndige danskere) alligevel ligger som målt. Og man slutter deraf, at det er OK at tage undersøgelsen for pålydende.

I en hvis forstand er argumentet rigtigt, men konklusionen er forkert. Jeg diskuterer problemstillingen her: http://journalisten.dk/gaetvaerk

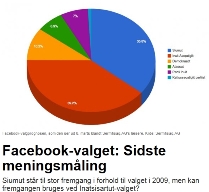

Grønlandske Facebook-brugere strømmer til Siumut

En stikprøve på næsten 2.000 vælgere er ganske mange. Ikke mindst i Grønland, hvor 40.000 indbyggere kan stemme til valget på tirsdag. Det er den grønlandske avis Sermitsiaq.AG, der har fået så mange svar i en meningsmåling på avisens Facebook-side.

Men partiet Siumut, der står til en stor fremgang, skal nok ikke glæde sig for tidligt, for stikprøven kan vise sig at ramme ret meget ved siden af. Ud over den almindelige statistiske usikkerhed er det nemlig langt fra sikkert, at de 1.927 deltagere i meningsmålingen er repræsentative for de grønlandske vælgere. Der kan for eksempel stilles følgende spørgsmål til en eventuel skævhed:

Men partiet Siumut, der står til en stor fremgang, skal nok ikke glæde sig for tidligt, for stikprøven kan vise sig at ramme ret meget ved siden af. Ud over den almindelige statistiske usikkerhed er det nemlig langt fra sikkert, at de 1.927 deltagere i meningsmålingen er repræsentative for de grønlandske vælgere. Der kan for eksempel stilles følgende spørgsmål til en eventuel skævhed:

- Er det kun stemmeberettigede, der har deltaget i afstemningen på Facebook?

- Er profilen for de grønlandske Facebook-brugere skæv i forhold til partivalg?

- Er der en skævhed i forhold til, hvem der klikker ind på Sermitsiaq.AG’s Facebook-side?

- Er især partiet Siumut bare god til at mobilisere sine tilhængere i forbindelse med den slags afstemninger – måske ud fra den betragtning, at medvind kan give ny gejst og yderligere opbakning?

Vi ved det ikke. Men vi ved, at det på andre tidspunkter i historien er gået galt med en meningsmåling, hvor man ikke har sikret sig, at stikprøven var udtaget simpelt og tilfældigt og dermed var repræsentativ for hele befolkningen. Det klassiske eksempel er fra kort før det amerikanske præsidentvalg i 1936, hvor den republikanske guvernør Landon stod til at vinde klart, men alligevel blev Franklin D. Roosevelt genvalgt med en historisk stor valgsejr.

Stikprøven ved meningsmålingen viste sig at være endog meget skæv, fordi den blandt andet kun omfattede forholdsvis velhavende amerikanere med et telefonapparat i huset.

Forud for det seneste Folketingsvalg foretog ekstrabladet.dk en måling, som ramte helt ved siden af landsresultatet samme dag. Dagen efter måtte avisen da også indrømme, at 84.608 ekstrabladet.dk-læsere godt kan tage fejl, selv om der var tale om landets største meningsmåling.

I forbindelse med det grønlandske valg har KNR, “Grønlands Radio”, i dag offentliggjort sin egen undersøgelse foretaget som en sms-afstemning a la X-Factor. “1.817 unikke mobiltelefoner”, 4,5 pct. af alle stemmeberettigede, deltog, og deres svar viser et noget andet resultat end Facebook-afstemningen hos Sermitsiaq.AG og omtales som en “chokmåling”. I forbindelse med den kan der imidlertid sættes mindst lige så store spørgsmålstegn ved deltagernes repræsentativitet.

Til både Sermitsiaq.AG’s og KNR’s ære skal nævnes, at de begge anfører, at der ikke er tale om videnskabelige, repræsentative undersøgelser. Hvad grønlænderne stemmer, ved vi på tirsdag.

To skridt frem – og tre tilbage

Nogen burde kortlægge omfanget af ikke-historier baseret på meningsmålinger. Den seneste uge bød på et par af slagsen:

Thorning haler ind på oppositionen i ny meningsmåling

S efter god meningsmåling: »Danskerne kan godt se, at statsministeren har ret«

Overskrifterne baserer sig på en ny måling fra Voxmeter, som tilsyneladende viser, at Socialdemokraterne er gået frem fra 20,6 procent (Voxmeter-måling kort før jul) til 22,6 procent af stemmerne.

De danske netmedier er blevet bedre til at oplyse om den statistiske usikkerhed, når de skriver om meningsmålinger. Det har Erik Gahner Larsen (m.fl.) for nylig dokumenteret. Usikkerheden oplyses da også i de to nævnte artikler. I førstnævnte artikel, som stammer fra Ritzau, får vi således at vide, at Bevægelserne ligger dog inden for målingens usikkerhed, som kan være op til 2,9 procentpoint for de største partier. Yes, det er korrekt. Bevægelserne ligger inden for målingens usikkerhed. Tjek selv efter her. Det er jo fint, at journalisten er opmærksom på problemet – og åbent og ærligt oplyser læseren om det. Vi får også at vide, hvor mange der har svaret, at undersøgelsen er repræsentativ, og hvornår den er gennemført. To skridt frem. Men æh …, når bevægelserne ligger inden for den statistiske usikkerhed, så ved vi ikke, om Thorning faktisk haler ind på oppositionen i den nye måling. Altså når målingen generaliseres til befolkningen. Der er således ikke belæg for rubrikken og vinklen.

Dette faktum afholder imidlertid ikke Ritzau fra at lave den – naturlige – opfølgende historie, hvor årsagsforklaringen køres i stilling: Fremgangen skyldes – ifølge Socialdemokraternes Magnus Heunicke – nytårstalen og de første synlige effekter af Socialdemokraternes lange seje træk. Også her oplyses om den statistiske usikkerhed, men konsekvensen drages ikke. Det er ikke kun undertegnede, som har studset over dette.

Lad os for en kort bemærkning dvæle ved Socialdemokraternes seneste målinger:

| Voxmeter | YouGov | Gallup | Voxmeter | Rambøll | Voxmeter | YouGov | Voxmeter | Voxmeter |

| 02-dec | 03-dec | 06-dec | 09-dec | 13-dec | 15-dec | 17-dec | 22-dec | 07-jan |

| 19,9 | 18,5 | 23,1 | 20,6 | 21,3 | 20,2 | 19 | 20,6 | 22,6 |

Som man kan se, går det lidt op og ned med målingerne. Der er ikke rigtig noget mønster eller nogen ensartet udvikling, og næsten alle målingerne ligger så tæt, at det er inden for den statistiske usikkerhed. Tager man målingerne for pålydende, kan man lave historierne om Socialdemokraternes fald og stigning og fald og stigning og fald og fald og stigning og stigning. Det er meningsløst, men man kan gøre det. Med udokumenterede vinkler, afledte politiske kommentarer og postulerede årsagsforklaringer. Med korrekte informationer, men forkerte konklusioner. Det er to skridt frem og tre tilbage.

Aviser bedst til meningsmålinger

Hvordan ser det ud med kvaliteten af de danske mediers formidling af meningsmålinger? Det spørgsmål findes der mange – sikkert overvejende kritiske – meninger om. Men ingen har tidligere systematisk undersøgt det. Før nu.

I det nye nummer af tidsskriftet Politik undersøger Erik Gahner Larsen og Simon Grundt Straubinger (begge SDU) formidlingen af meningsmålinger hos Politiken, Ekstra Bladet, Jyllands-Posten og Berlingske Tidende under de seneste tre folketingsvalgkampe (2005, 2007 og 2011). I alt analyseres 424 artikler fra både aviser og web i artiklen Mediernes formidling af meningsmålinger: Indholdsanalyse af folketingsvalg, 2005-2011.

Hovedkonklusionerne er

- Der formidles flere og flere meningsmålinger på internettet i forhold til i aviserne

- Intet taler for, at meningsmålinger formidles systematisk dårligere i Danmark end i andre lande

- Meningsmålinger er historisk set blevet formidlet bedre i aviserne end på internettet

- Statistisk usikkerhed formidles over tid bedre og bedre i artikler på internettet (min konklusion).

Analysen tager udgangspunkt i Esomar/Wapor-standarderne, der angiver en række kriterier, medierne bør opfylde, når de formidler meningsmålinger. Der opregnes syv metodiske informationer, som medierne ifølge Esomar bør fortælle læseren:

- Instituttet bag meningsmålingen

- Medieaktøren (som finansierer målingen)

- Stikprøvens størrelse

- Ordlyden af spørgsmålet

- Statistisk usikkerhed

- Indsamlingsperioden

- Metoden (Cawi, Cati, kombinationsmålinger etc.)

I analysen kortlægges formidlingen af de 424 artikler, og der laves en komparativ analyse, hvor man sammenligner med formidlingen af meningsmålinger i udenlandske medier (desk study). Endelig tester forfatterne fire hypoteser om, hvad der kan være årsag til forskellige niveauer af formidling i den danske dækning.

Analysen gør os specielt klogere på de danske forhold, mens den komparative del står svagere, da en række af de udenlandske undersøgelser må formodes ikke at være direkte sammenlignelige (på områder som web- versus printartikler, forskellig tidsperiode, forskellige medier/medietyper, studier under valgkampe versus studier af hele år osv.). Forfatterne er opmærksomme på denne svaghed og afholder sig af samme grund fra at konkludere ret meget på den komparative del.

Man kan naturligvis diskutere analysens medievalg (ingen gratisaviser og hverken DR eller TV2), som jeg gerne havde set bredere. Man kan også diskutere Esomars syv punkter. Analysen mangler efter min mening at medtage et punkt 8 (andel ved-ikke svar) og punkt 9 (svarprocent) som supplement til Esomars guidelines. Det er to vigtige informationer at få som læser.

Disse indvendinger ændrer dog ikke ved, at der er tale om en spændende og hidtil savnet analyse, som jeg vil anbefale enhver med interesse for området at ofre de 30 kroner på, som e-artiklen koster hos DJØF Forlag.

Er analyseinstitutterne ens?

Uanset hvilke medier man følger, kan man næsten dagligt læse, at den seneste meningsmåling viser.

Ethvert større dansk mediehus har sin egen hel eller halveksklusive aftale med et analyseinstitut: Epinion, TNS Gallup, Voxmeter, YouGov, Megafon og hvad de nu ellers hedder.

Men hvordan arbejder institutterne egentlig? Og hvad skal man som journalist eller bare almindelig medieforbruger være opmærksom på rent metodisk? Jeg vil her ridse nogle af de metodiske forskelligheder og karakteristika op.

Adgang til svarpersoner

Der anvendes grundlæggende tre indsamlingsmetoder: Telefoninterviews (CATI), webpaneler (CAWI) og en kombination af begge. YouGov anvender udelukkende webpanel, mens flertallet af de øvrige institutter arbejder med en kombi-model (fx med fordelingen 50-50, 60-40 eller 80-20). Der findes også institutter, som kun anvender CATI til politiske meningsmålinger. Og for at gøre forvirringen total er der også institutter, som varierer metoderne nærmest fra måling til måling.

Traditionelt har man kritiseret webpaneler for ikke at være repræsentative. Kritikken går blandt andet på, at ældre mennesker og lavtuddannede er underrepræsenterede, og at man påvirker folk i panelet gennem de spørgsmål, man stiller dem. Løbende udskiftning af panelets medlemmer kan til en vis grad afbøde problemet med påvirkning. Erfaringer fra bl.a. folketingsvalget i 2011 viser imidlertid, at webpaneler i nogle tilfælde ramte mere præcist end telefonbaserede målinger. Det er med andre ord ikke længere helt så selvfølgeligt, at CATI er bedst. Det er til gengæld klart, at CAWI er billigst. Kombi-metoden har dog stadig den – i hvert fald teoretiske – fordel, at man bedre kan sikre en demografisk repræsentativ svargruppe.

Kvaliteten af webpanelet

Kvaliteten af webpanelerne er – og bliver i tiltagende grad – et afgørende konkurrenceparameter. Her skal man særligt være opmærksom på panelets størrelse og sammensætning, den løbende udskiftning af panelets medlemmer og de baggrundsoplysninger, man indhenter på medlemmerne. Man skal også være opmærksom på, hvordan respondenterne er rekrutteret og eventuelle skævheder som følge heraf – er de fx selvrekrutterede eller inviterede eller købt fra et eller andet medlemsregister? Erfaring med webpaneler er et andet afgørende parameter. Det tager tid (og valg) at opdage et webpanels eventuelle indbyggede skævheder og lære at justere med relevante vægte.

Indsamling via webpaneler

Man skulle måske tro, at indsamlingen af panel-svar foregår på samme måde på tværs af institutterne. Det er dog ikke tilfældet. Nogle institutter anvender præstratificering, hvor de på forhånd udtrækker en repræsentativ stikprøve blandt panelets medlemmer. Hvis man her opnår en svarprocent nær 100, behøver man faktisk ikke nogen efterfølgende vægtning af svarene eller løbende kontrol. Det kræver dog, at man bruger ressourcer på at sikre en meget høj svarprocent.

Andre institutter anvender kvoteopfyldelse, hvor repræsentativiteten sikres løbende og automatisk i takt med, at svarene tikker ind. Her registreres med andre ord de hurtigste svar blandt panelets medlemmer. Det åbner op for nogle mulige skævheder, som ikke gør sig gældende ved præstratificerede stikprøver.

Endelig er der institutter, som kombinerer metoderne ved at udtrække en præstratificeret stikprøve og herefter løbende følger, om kvoterne opnås på de enkelte strata (og løbende supplerer kvoterne, hvor der måtte mangle svar). Det er naturligvis nødvendigt, hvis man ikke opnår den helt høje svarprocent, og der er systematiske skævheder.

Håndtering af tvivlere

Ved politiske meningsmålinger stiller institutterne det enslydende spørgsmål: Hvilket parti ville du stemme på, hvis der var folketingsvalg i morgen? Det er imidlertid ikke alle danskere, der har en klar holdning til partivalg. Nogle – ofte 10-15 procent – udtrykker i første omgang tvivl, når man stiller dem spørgsmålet. De fleste institutter prober. Det betyder, at de forsøger at vriste et svar ud af tvivlerne, fx ved at stille et opfølgende spørgsmål: Hvilket parti vil du mest sandsynligt stemme på? Eller: Hvilke partier kunne komme på tale/hælder du til? Det får en del af tvivlerne til at tilkendegive en holdning, og disse lidt usikre stemmer regnes så typisk ind på lige fod med dem, der har en sikker politisk overbevisning. Tilbage står en lille restgruppe af hårde tvivlere. De fleste institutter oplyser, at denne restgruppe smides ud eller ikke tillægges nogen betydning, når de estimerer mandat- og procentfordelingerne. Argumentet er, at det er for usikkert at forsøge at gætte dem ud. Nogle af disse tvivlere vil givetvis også tilhøre gruppen af sofavælgere eller stemme blankt.

Imidlertid indgår tvivlergruppen som regel i den oplyste sample size, dvs. i den oplyste stikprøve. Det betyder i praksis, at gruppen behandles, som om den ville stemme som ikke-tvivlerne. I virkeligheden burde man enten fjerne denne gruppe fra den oplyste stikprøve eller tydeligt skrive, at tvivlergruppen udgør xx procent og bør trækkes fra stikprøven, hvis man ønsker at beregne den statistiske usikkerhed. Måske flueknepperi og marginalt, men alligevel. Der findes givetvis også institutter, som vægter tvivlerne ind. Men her er vi inde og pille ved forretningshemmelighederne.

Metodisk forskellighed

Der er selvfølgelig andre ting, der differentierer institutterne: Hvordan vægter man svarene – hvis man vægter dem? Hvordan håndterer man førstegangsvælgere? Hvordan håndterer man, at folk har svært ved at huske (eller har fortrængt), hvad de stemte ved seneste valg?

Pointen er, at der formentlig er større metodisk forskellighed mellem institutterne, end de fleste forestiller sig. Og at vi pt. befinder os i en overgangsfase i forhold til adgang til svarpersoner.

Det er imidlertid vanskeligt at rangordne institutterne. Målingerne op til seneste folketingsvalg viste, at ingen af institutterne ramte helt skævt – eller helt præcist. Institutterne er nogenlunde enige om at spørge mellem 1000 og 1500 personer. Her kunne de differentiere sig. Og fx spørge 5000 repræsentative danskere. Det ville give større præcision – uanset metode.

(Dette indlæg bygger bl.a. på interviews med en række af de toneangivende danske analyseinstitutter)

Målingerne ramte skævt

Gårsdagens valgresultat vækker næppe professionel begejstring hos landets meningsmålingsinstitutter. Ved valget i 2007 ramte institutterne således noget tættere på resultatet, end tilfældet har været i år.

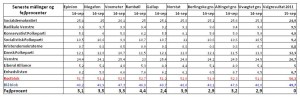

Her er overblikket over institutternes fejlprocenter*. I tabellen kan du også se fejlprocenter for Berlingske Barometer, Altingets gennemsnit og det uvægtede gennemsnit, som dagligt er blevet præsenteret her på siden.

Gallup kom i år tættest på med en fejlprocent på 2,4. Til sammenligning havde Megafon og Catinét i 2007 fejlprocenter på blot 1,2 og 1,8. Ingen af gennemsnitsmålene kom for alvor tæt på, men de blev dog kun slået af Gallup. Det uvægtede gennemsnit af de seneste 5 målinger viste sig at være mindst lige så retvisende, som Berlingske Barometer og Altingets mere avancerede modeller.

Hvad gik galt? Venstre og SF snød institutterne. Henholdsvis positivt og negativt. Omvendt lykkedes det i år at estimere tilslutningen til Dansk Folkeparti – noget som voldte enkelte institutter store problemer i 2007.

Tidsfaktoren spiller naturligvis en rolle: Der kan ske noget politisk på selve valgdagen, som målingerne ikke når at registrere. Men det er svært at pege på noget konkret ved årets valg. Måske er svaret helt enkelt, at institutterne ikke fik estimeret tvivlerne godt nok.

Hør indslag i Detektor på P1, hvor jeg udtaler mig om, hvordan målingerne ramte.

*Fejlprocent betyder, hvor mange procentpoint, der skal flyttes i en måling for at ramme valgresultatet. fejlprocenten er beregnet som summen (numerisk) af forskellene mellem de enkelte partiers valgresultatet og den enkelte målings estimat af samme. Summen er herefter divideret med to. Summen divideres med to, for at fejl ikke kommer til at tælle dobbelt (hvis et parti estimeres for højt, vil et andet parti jo nødvendigvis estimeres for lavt, når summen skal give 100%). Modellen er udarbejdet af Søren Risbjerg Thomsen, professor og valgekspert, Aarhus Universitet.