Klimapolitik er danskernes foretrukne valgtema. Forleden kunne man læse denne opsigtsvækkende nyhed hos den grønne tænketank Concito. Dagen forinden havde Berlingske imidlertid fortalt, at flygtninge- og indvandrerpolitikken ifølge danskerne er det vigtigste politikområde for en kommende regering. Flere medier undrede sig behørigt over de strittende budskaber. DR’s Detektor tog fat i undersøgelserne og skrev en glimrende artikel om metodeproblemerne ved Concitos undersøgelse, men kom ikke hele vejen rundt. Her er den lidt længere – og lidt mere nørdede – version.

Priming

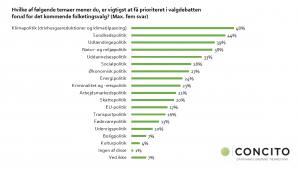

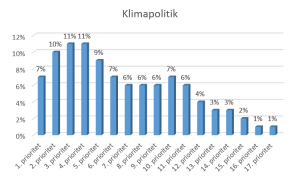

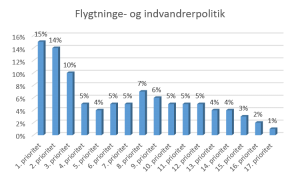

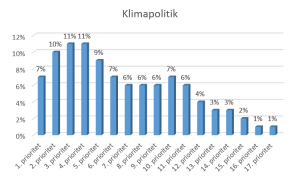

Concitos undersøgelse bygger på en survey med 27 spørgsmål, som alle handler om klimaforandringer, grøn omstilling, drivhusgasser og klimaudfordringen. Efter de første 26 spørgsmål kommer så spørgsmålet om valgtemaer: “Hvilke af følgende temaer mener du, er vigtigst at få prioriteret i valgdebatten forud for det kommende folketingsvalg?” De 1076 respondenters svar fordelte sig således:

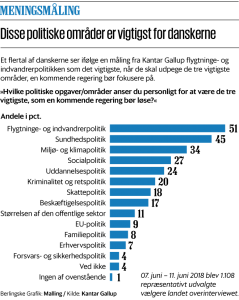

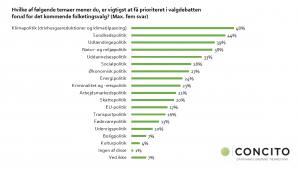

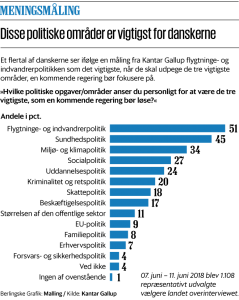

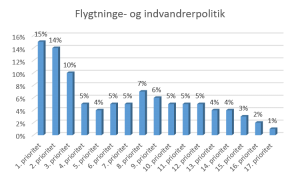

Problemet er, at respondenterne primes pga. måden, spørgeskemaet er bygget op. Priming kan defineres som “an implicit memory effect in which exposure to a stimulus influences a response to a later stimulus”. Altså en implicit hukommelseseffekt, hvor personen udsættes for et stimuli (her 26 klimaspørgsmål), hvilket påvirker personens svar på et senere stimuli (her spørgsmål 27 om valgtemaer), uden at personen selv er opmærksom på det. Det er derfor velegnet til manipulation og børnelærdom inden for marketing og salg. Det er bestemt ikke sikkert, at Concito gør det med intention om at manipulere resultatet. Men i praksis er det det, der sker. Der etableres en underliggende præmis om, at klimaområdet er vigtigt. En situationsbias. Er Berlingskes undersøgelse så et hak bedre? Ja, det er den faktisk. For den indeholder ikke 26 forudgående stimuli-spørgsmål. De spørger direkte ind til “de vigtigste politikområder” og får denne svarfordeling:

Repræsentative svarpersoner

Når man undersøger danskernes foretrukne valgtemaer, skal det gøres med repræsentative udsnit (stikprøver) af den voksne danske befolkning. Begge undersøgelser er gennemført af anerkendte analysebureauer (Analyse Danmark og Kantar Gallup), som normalt gør en dyd ud af at fortælle, at svarpersonerne er repræsentativt udvalgte vælgere. Det hviler på en underliggende forudsætning om, at de udvalgte personer faktisk svarer. Er der frafald, kan det være med til at skævvride undersøgelsen og gøre den ikke-repræsentativ. Hvis det sker, er der problemer med den eksterne validitet. Frafald kan opstå undervejs i en undersøgelse. Der er risiko for, at svarpersonen giver op, hvis der er mange spørgsmål; hvis spørgsmålene virker uvedkommende; hvis man er uenig i præmissen for undersøgelsen. I en undersøgelse med 27 spørgsmål om klima er der risiko for, at svarpersoner giver op, hvis de ikke interesserer sig for klimaet og ikke mener, at det er et vigtigt politisk tema. Det kan potentielt skævvride undersøgelsens resultater. Det oplyses, at der undervejs i undersøgelsen sker et frafald på 8 procent. Vi ved ikke, om nogle af dem falder fra på grund af manglende interesse for emnet. Men risikoen er til stede.

Hvad betyder “foretrukne” og “vigtigst”?

Berlingske præsenterer med egne ord politikområder, som er “vigtigst for danskerne”. Concito taler om “danskernes foretrukne valgtema”. Men hvordan kommer man rent metodisk frem til “foretrukne” og “vigtigst”?

For det første opstiller man to forskellige lister med politikområder. Concito udvælger 17 valgtemaer, mens Berlingske udvælger 13 politiske områder. Det er svært på den baggrund at tale om objektive eller direkte sammenlignelige målinger af, hvad danskerne foretrækker. Der er (naturligvis) allerede på forhånd truffet nogle valg for svarpersonerne. Disse valg er præmisser og er forskellige for de to undersøgelser.

For det andet giver man ikke svarpersonerne det samme antal krydser at sætte. Concito lader svarpersonerne sætte fem krydser, mens Berlingske lader sine svarpersoner sætte tre krydser. Er det nu vigtigt? Ja! Det kan faktisk være helt afgørende for undersøgelsens resultat.

Lad mig illustrere pointen med to fiktive holdningsfordelinger, jeg har opfundet til lejligheden:

Tag et godt kig på de to fordelinger. Har du gættet pointen?

Hvis vi vælger Concitos model med fem krydser (hver person sætter kryds for de fem områder, som har højest prioritet), så vil 48% pege på klimapolitik. Og 48% vil pege på flygtninge- og indvandrerpolitik. Ergo har vores undersøgelse nu vist, at befolkningen peger på de to områder som lige vigtige.

Hvis vi derimod vælger Berlingskes model med tre krydser, så vil 28% pege på klimapolitik. Mens 39% vil pege på flygtninge- og indvandrerpolitik. Ergo har vores undersøgelse nu vist, at befolkningen klart peger på flygtninge- og indvandrerpolitik som vigtigst.

Jamen det var jo den samme undersøgelse med de samme spørgsmål og de samme svarpersoner? Nemlig. Vi vælger bare at kigge på to forskellige udsnit af disse personers politiske præferencer. Og det gør en verden til forskel. Ja, det giver faktisk to radikalt forskellige nyhedshistorier. Og hvad værre er: Vi kan ikke på forhånd entydigt sige, om det er mest korrekt at lade svarpersonerne sætte 1, 2, 3 eller 5 krydser. Men vi kan i det mindste være opmærksomme på problemstillingen.

Som sagt er fordelingerne fiktive. Vi ved ikke, hvordan det havde set ud, hvis Concito havde begrænset sig til tre krydser. Eller hvis Berlingske havde tilladt fem. Men “danskernes foretrukne temaer” og “de vigtigste politikområder” havde formentlig set anderledes ud.

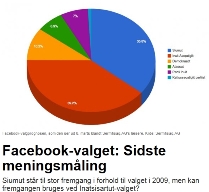

Men partiet Siumut, der står til en stor fremgang, skal nok ikke glæde sig for tidligt, for stikprøven kan vise sig at ramme ret meget ved siden af. Ud over den almindelige statistiske usikkerhed er det nemlig langt fra sikkert, at de 1.927 deltagere i meningsmålingen er repræsentative for de grønlandske vælgere. Der kan for eksempel stilles følgende spørgsmål til en eventuel skævhed:

Men partiet Siumut, der står til en stor fremgang, skal nok ikke glæde sig for tidligt, for stikprøven kan vise sig at ramme ret meget ved siden af. Ud over den almindelige statistiske usikkerhed er det nemlig langt fra sikkert, at de 1.927 deltagere i meningsmålingen er repræsentative for de grønlandske vælgere. Der kan for eksempel stilles følgende spørgsmål til en eventuel skævhed: