Da agurkesæsonen i juli peakede i et slags omvendt proportionalt kapløb med det elendige sommervejr, kunne man hos Metroxpress læse Ny undersøgelse: Denne sport synes danske unge er MINDST sexet.

Kan ikke modstå maddingen. Jeg begynder at bladre den illustrerede liste med sportsgrene igennem. 0%. 0%. Hmm, gad vide hvad det betyder? Efter et par klik sker det. Et voldsomt ubehag rammer mig. Bladrer hurtigt frem, hurtigt tilbage, hurtigt frem igen. Har jeg misforstået listen? Nej, en hurtig skimning af artiklen bekræfter mine bange anelser. Ubehaget er nu blevet til kvalme. Jeg ser dem i glimt for mig. Waldner. Maze. Tugwell. Pedersen. Min ungdoms idoler. Nu reduceret til ikoner for den mindst sexede sportsgren. I Danmark. Ifølge unge. Bordtennis.

Værre: Det er ifølge den citerede køns- og til lejligheden showforsker, Karen Sjørup, slet ikke underligt, for bordtennis er en sport, der ikke er “meget show i”. Aaav.

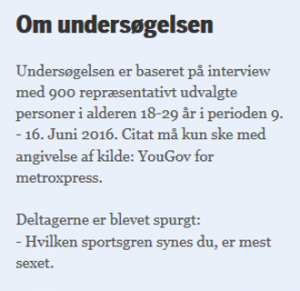

Noget må være galt med den undersøgelse. Den MX-journalist har da vist været ramt af fikseringsfejl. Og det var da også en helt utrolig negativ vinkel. Jeg beslutter mig for i videnskabens tjeneste at kaste et KRITISK blik på metoden bag. Er undersøgelsen overhovedet repræsentativ? Tages der højde for den statistiske usikkerhed? Og hvad med målingsvaliditeten? Måler man faktisk det, man tror? Heldigvis har analysefirmaet bag, YouGov, været flinke og varedeklarere, og Metroxpress har været flinke at bringe deklarationen. Den ser sådan her ud:

Nedslået må jeg konstatere, at der ikke umiddelbart er noget alvorligt at udsætte på repræsentativiteten. Svarpersonerne kommer ganske vist næsten med sikkerhed fra YouGovs webpanel, og de rekrutterer ikke via simpel tilfældig udvælgelse, så måske kan der være systematiske forskelle, når man sammenholder de 900 svarpersoner med “alle danske unge”? Ja, det kan der godt. Men det er næppe noget, der rykker fundamentalt ved de overordnede resultater.

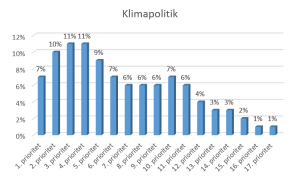

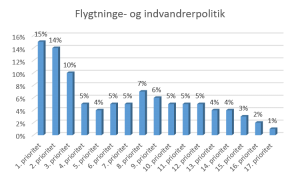

Nå, hvad så med den statistiske usikkerhed? Den er da vist blevet glemt i skyndingen? HVIS man tager højde for usikkerheden, kan man med rette så tvivl om, hvem der ligger sidst, næstsidst og tredjesidst osv. på listen. De nederste sportsgrene på listen har nemlig alle det til fælles, at de har fået lige omkring nul stemmer. Okay, så rubrikken er altså lidt skråsikkert konkluderende. Der kan sagtens være tale om en fejludråbt taber. Måske er den virkelige bundskraber karate eller ishockey? Eller en af de sportsgrene, som slet ikke optræder på Metroxpress’ ikke-udtømmende liste over sportsgrene? Mit humør stiger en anelse. Min mission – at genoprette Maze og Co.’s anseelse – er tilbage på sporet.

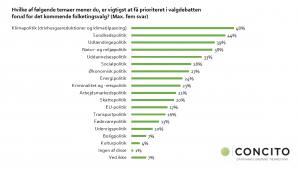

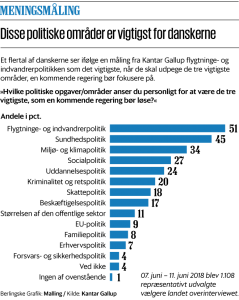

Men der er større og mere interessante problemer. For hvad er det egentlig, de 900 unge har svaret på? Spørgsmålet lyder: “Hvilken sportsgren synes du, er mest sexet?” Men kan man derudfra konkludere, hvad der er mindst sexet? Nej. Hvis man vil vide, hvad der er mindst sexet, så skal man … yes, rigtigt … spørge om det. Og her kommer de upopulære ministre ind i billedet. For hvis man vil undersøge, hvilke ministre der er mindst populære, så skal man også spørge om det. Og IKKE spørge, hvem der er mest populær. Det har Erik Gahner Larsen tidligere overbevisende demonstreret. Der er med andre ord tale om et problem, vi møder i andre sammenhænge i nyhedsstrømmen.

Undersøgelsen kan altså ikke bruges til at sige noget om, hvilken sportsgren der er mindst sexet. Jeg kan mærke, at denne her analyse er god. Det føles helt rigtigt. Det slår mig, at jeg burde sende et link til DBTU’s presseansvarlige. Og Maze. Han er sikkert også nedtrykt.

Men fortæller undersøgelsen så faktisk, hvilken sportsgren der er mest sexet? Njah, det kan man faktisk godt sætte spørgsmålstegn ved. I undersøgelsen peger hele 15 procent på fodbold som den mest sexede sportsgren. Til det kan man indvende to ting:

1) Er det i virkeligheden en kombination af eksponering, tilslutning og sexethed, vi måler? På samme måde, som man vanskeligt kan vurdere en ny-udnævnt (ikke-eksponeret) minister, kan man vel vanskeligt pege på de mindst eksponerede/dyrkede sportsgrene?

2) Hvad nu, hvis 15 procent samtidig peger på fodbold som direkte usexet? Altså, forudsat at de 900 unge fik chancen for at tage stilling til usexethed. Lad os rent hypotetisk forestille os, at fodbold deler vandene. Måske svarer de 15 procent, som dyrker fodbold, at det er mest sexet. Mens deres respektive partnere svarer, at det er dybt usexet. Det ville være et lidt ærgerligt resultat for de pågældende. Men tænkeligt. Ministerparallellen er til at få øje på. Støjberg.

Det konstruktive

Alternativt og bedre (!) kan man bede svarpersonerne bedømme hver enkelt sportsgren på en skala fra 1-5. Det gør YouGov da også i deres ministermålinger. På den måde kan man både se, hvem der får flest ekstreme værdier (1 og 5) og rangliste sportsgrenene efter deres gennemsnitsscorer eller efter andel positive minus andel negative bedømmelser. Det ville – måske – give helt andre resultater. Kan du også mærke endorfinerne nu, Maze? Og lad os så få det show.