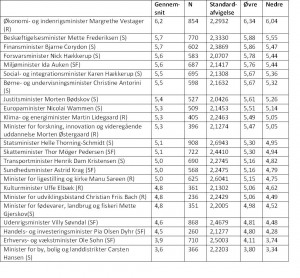

Kulturvaneundersøgelsen – den nye, monumentale, tilbagevendende, og særdeles grundige – har fået megen medieomtale de seneste uger. Men ikke den slags omtale, som Kulturministeriet (rekvirent), Epinion og Pluss Leadership på forhånd kunne håbe på.

Sagen tog sin begyndelse, da Stig Jarl, lektor i teatervidenskab, i Politiken leverede en analyse med det hovedbudskab, at danskernes rapporterede teaterbesøg var skudt helt forbi og dermed løgn. Det blev startskuddet til en serie af kritiske artikler om undersøgelsens validitet og troværdighed generelt. Jeg blev selv interviewet til Information om undersøgelsen i sidste uge.

Men hvad er egentlig op og ned i sagen? Lad mig starte med at slå fast, at der er tale om en omfattende og grundig undersøgelse, som rent metodisk ikke lader meget tilbage at ønske.

Man må stille to grundlæggende kritiske spørgsmål til en undersøgelse af denne type, nemlig 1) Hvad vil man undersøge, og hvordan er spørgsmålene formuleret? og 2) Hvordan er svarpersonerne udvalgt, og er de faktisk repræsentative for os danskere?

Til det sidste kan man konstatere, at der er tale om store og i udgangspunktet repræsentative stikprøver; at den overordnede svarprocent ligger omkring 50%, hvilket er normalt, men naturligt har givet anledning til en grundig bortfaldsanalyse, som ikke peger på ret store skævheder. Dog er børnefamilier overrepræsenterede. Det problem har man efterfølgende vægtet sig ud af. Repræsentativiteten er derfor ikke et stort problem.

Til det første kan man konstatere, at 1) undersøgelsesemnet – kulturvaner (og herunder medievaner) – er et følsomt område, forbundet med forskellige grader af social status og knyttet til de kulturværdier, vi hver især bærer rundt på. Forskning på området viser, at socialt følsomme emner ikke kan afdækkes præcist gennem spørgeskemaundersøgelser. Det er med andre ord et grundlæggende problem, som ikke handler om kvaliteten af den konkrete undersøgelse. Noget af usikkerheden kan naturligvis afdækkes ved at sammenholde svarene med registerbaserede oplysninger, fx om solgte teaterbilletter og operabilletter. 2) En række spørgsmål er formuleret anderledes i 2012-undersøgelsen i forhold til den seneste tilsvarende undersøgelse fra 2004. Det er der en række gode grunde til, som der argumenteres sagligt for i undersøgelsen. Bl.a. hensyn til den teknologiske udvikling i den mellemliggende periode og hensyn til sammenlignelighed med internationale undersøgelser på området.

Problemet er med andre ord ikke undersøgelsen an sich. Problemet er i stedet, hvis man

1) ukritisk tager konklusionerne om vores alle sammens kulturvaner som sandhedsvidne – og ikke blot som det pejlemærke eller fingerpeg, det vitterligt er;

2) konkluderer om udviklingen fra 2004-2012 uden smålig skelen til, hvordan man faktisk har spurgt, herunder om man har ændret i formuleringer og definitioner mellem de to undersøgelser.

Der mangler med andre ord en nuanceret og kritisk læsning og formidling af undersøgelsen. Her kunne kulturministeren passende selv gå forrest i stedet for at lade begejstringen løbe af med sig, når han i ministeriets egen pressemeddelelse udtaler, at børnene “… er meget aktive og læser for eksempel markant flere bøger end i 2004, hvor den forrige kulturvaneundersøgelse fandt sted.” Det ved vi så faktisk ikke noget om, da man i 2012-undersøgelsen har spurgt børnene hvor ofte de læser/hører bøger. Mens man i 2004 spurgte børnene, hvor ofte de læser bøger. Det er dog to forskellige ting.